맥미니, 로컬 AI 슈퍼컴퓨터로 변신하다!

가만히 있던 여러분의 맥미니 또는 맥 스튜디오가 갑자기 최첨단 로컬 AI 슈퍼컴퓨터로 변모할 수 있다면 믿으시겠습니까? 최근 macOS Sonoma 14.2 업데이트가 가져온 놀라운 변화를 통해, 평범했던 맥이 AI 시대를 선도하는 강력한 도구로 재탄생했습니다. 특히 썬더볼트 5와 RDMA(Remote Direct Memory Access) 지원이 그 핵심인데요, 이 기술이 대체 무엇이며, 우리의 맥 환경에 어떤 혁신을 가져올지 함께 살펴보시죠.

RDMA: AI 성능을 비약적으로 끌어올리는 기술

RDMA를 이해하려면 먼저 DMA(Direct Memory Access)를 알아야 합니다. 기존에는 CPU가 메모리 접근을 일일이 제어했지만, DMA는 CPU 개입 없이 주변 장치가 메모리에 직접 접근하여 데이터를 읽고 쓸 수 있게 합니다. 이는 CPU의 부담을 줄이고 데이터 전송 속도를 크게 향상시키는 기술이죠. 여기서 RDMA는 이 DMA 개념을 ‘네트워크 너머’로 확장한 것입니다. 즉, 네트워크로 연결된 여러 컴퓨터의 메모리가 마치 한 컴퓨터의 메모리처럼 직접 소통할 수 있게 되는 것이죠. AI 모델이 여러 장치에 분산되어 있을 때, 각 장치의 메모리가 CPU의 개입 없이 직접 데이터를 주고받을 수 있다면, 데이터 병목 현상을 획기적으로 줄여 AI 연산 속도를 엄청나게 빠르게 만들 수 있습니다.

썬더볼트 5와 데이지 체인: 맥미니 클러스터의 핵심

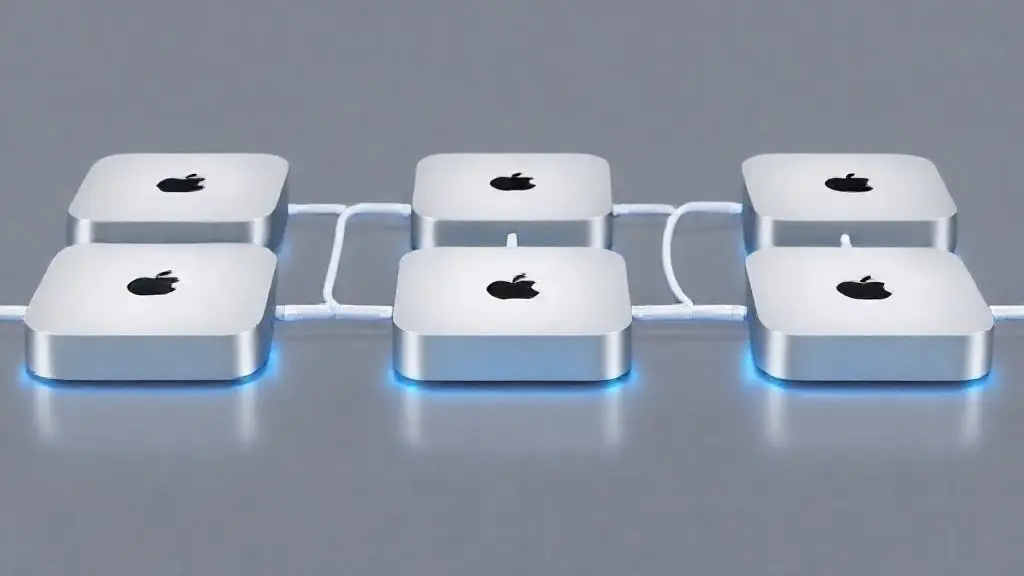

이번 macOS Sonoma 14.2 업데이트의 핵심은 바로 ‘RDMA 오버 썬더볼트’ 지원입니다. 이전에도 맥미니를 연결하여 클러스터를 구축하는 시도는 있었지만, TCP 기반의 일반 네트워크 통신은 지연 시간이 길고 CPU 개입이 많아 병목 현상이 심했습니다. 그러나 썬더볼트 5가 RDMA를 공식 지원하면서 상황이 완전히 달라졌습니다. 썬더볼트 5는 초고속 데이터 전송 속도를 제공하며, ‘데이지 체인’ 방식으로 여러 장치를 직렬로 연결할 수 있습니다. 이제 맥미니 여러 대를 썬더볼트 케이블로 간단히 연결하기만 해도, OS 차원에서 RDMA를 통해 서로의 메모리에 직접 접근하며 마치 하나의 거대한 AI 슈퍼컴퓨터처럼 작동하게 되는 것입니다.

로컬 AI 시대의 도래와 애플의 영리한 전략

이러한 변화는 특히 로컬 AI 환경에 큰 의미를 가집니다. 일반적으로 70B(700억) 파라미터급의 대규모 언어 모델(LLM)을 로컬에서 구동하려면 막대한 메모리 용량이 필요합니다. 예를 들어, 48GB 메모리를 가진 맥미니 두 대를 RDMA 기반 썬더볼트 5로 연결하면 총 96GB의 메모리를 활용하는 AI 클러스터가 되어, 이전에는 불가능했던 대규모 LLM도 로컬에서 원활하게 구동할 수 있게 됩니다. 이는 개인 정보 보호가 중요한 작업이나, 클라우드 비용 없이 자체적으로 AI 개발 환경을 구축하려는 개발자들에게 혁신적인 기회를 제공합니다. 애플은 클라우드 사업자가 아니기 때문에, 온디바이스 AI와 로컬 클러스터 지원이라는 자신들의 강점을 살리는 방향으로 AI 전략을 펼치고 있는 것으로 보입니다. 이번 업데이트는 애플이 AI 시대에 어떻게 대응할지에 대한 흥미로운 단서를 보여주며, 앞으로 맥 환경에서 펼쳐질 AI 혁신을 기대하게 만듭니다.